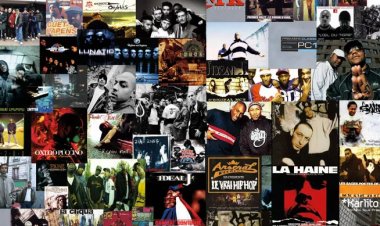

Un algorithme de Facebook confond des personnes noires avec des singes

Un algorithme de recommandation de Facebook a demandé à des utilisateurs s’ils souhaitaient voir d’autres “vidéos sur les primates” sous une vidéo d’un tabloïd britannique montrant des personnes noires, a révélé le New York Times vendredi 3...

REJOINDRE L'ÉQUIPE DE RÉDACTION

Tu penses avoir un don pour la rédaction ?

Contacte-nous dès maintenant pour rejoindre notre équipe de bénévoles.

REJOINDRE L'ÉQUIPE DE RÉDACTION

Tu penses avoir un don pour la rédaction ?

Contacte-nous dès maintenant pour rejoindre notre équipe de bénévoles.

REJOINDRE L'ÉQUIPE DE RÉDACTION

Tu penses avoir un don pour la rédaction ?

Contacte-nous dès maintenant pour rejoindre notre équipe de bénévoles.

Un algorithme de recommandation de Facebook a demandé à des utilisateurs s’ils souhaitaient voir d’autres “vidéos sur les primates” sous une vidéo d’un tabloïd britannique montrant des personnes noires, a révélé le New York Times vendredi 3 septembre.

La vidéo du Daily Mail, vieille de plus d’un an, est intitulée “un homme blanc appelle les flics contre des hommes noirs à la marina”. Elle ne montre que des personnes, pas de singes.

En dessous, la question “voir plus de vidéos sur les primates ?” avec les options “Oui / Rejeter” s’est affichée sur l’écran de certains utilisateurs, d’après une capture d’écran diffusée sur Twitter par Darci Groves, une ancienne designer du géant des réseaux sociaux.

“C’est scandaleux”, a-t-elle commenté, appelant ses ex-collègues de Facebook à faire remonter l’affaire.

“C’est clairement une erreur inacceptable”, a réagi une porte-parole de Facebook, sollicitée par l’AFP. “Nous présentons nos excuses à quiconque a vu ces recommandations insultantes.”

“Nous avons des progrès à faire”

Le groupe californien a désactivé l’outil de recommandation sur ce sujet “dès que nous nous sommes aperçus de ce qui se passait afin d’enquêter sur les causes du problème et empêcher que cela ne se reproduise”, a-t-elle précisé.

“Comme nous l’avons dit, même si nous avons amélioré nos systèmes d’intelligence artificielle, nous savons qu’ils ne sont pas parfaits et que nous avons des progrès à faire”, a-t-elle continué.

L’affaire souligne les limites des technologies d’intelligence artificielle, régulièrement mise en avant par la plateforme dans ses efforts pour construire un fil personnalisé à chacun de ses près de 3 milliards d’utilisateurs mensuels.

Elle s’en sert aussi beaucoup dans la modération des contenus, pour identifier et bloquer des messages et images problématiques avant même qu’ils ne soient vus.

Mais Facebook, comme ses concurrents, est régulièrement accusé de ne pas lutter suffisamment contre le racisme et d’autres formes de haine et de discriminations.

Le sujet suscite d’autant plus de tensions que de nombreuses organisations de la société civile accusent les réseaux sociaux et leurs algorithmes de contribuer à la division de la société américaine, dans le contexte des manifestations du mouvement “black Lives Matter” (les vies noires comptent).

À voir également sur Le HuffPost: Ces stories complotistes de Kim Glow, pire promo pour le documentaire “Hold-up”

Une enquête ouverte après la publication pro-talibans d'un prof de Nancy

Une enquête ouverte après la publication pro-talibans d'un prof de Nancy Comment Facebook essaye de protéger les Afghans des Talibans

Comment Facebook essaye de protéger les Afghans des Talibans

![Plus belle la vie en avance : résumé de l'épisode du lundi 17 octobre 2022 [SPOILERS]](http://fr.web.img3.acsta.net/newsv7/22/10/13/11/50/1856008.jpg?#)